Ein paar Gedanken zu Backup-Strategien mit rsync, NAS, ownCloud oder andere Cloud-Diensten (Online-Festplatte / HiDrive)

Datenverlust ist oft eine Katastrophe. Deswegen versuchen wir unsere Daten so gut wie möglich zu schützen. Als Privatperson haben in der Regel nicht die Möglichkeit, uns eine Band-Bibliothek oder ein kleines Rechenzentrum in den Keller zu stellen. Der Kostenaufwand rechtfertigt in der Regel den Nutzen hinten und vorne nicht.

Trotzdem will auch der normale Heim-Anwender seine Daten sichern. Nun lassen sich Backups auf verschiedene Weise realisieren. Egal, wie man es macht, es ist immer falsch oder richtig.

Ich will in diesem Beitrag nicht über Verschlüsselung oder sonstiges reden, sondern nur über die Backup-Strategie selbst. Wer seine Backups oder Dateien dann wie und womit verschlüsselt, liegt beim jeweiligen Anwender selbst.

Backup ist etwas für Feiglinge! … aber wohl dem, der eines hat …

Externe Festplatte

Das ist natürlich der Klassiker. Ich habe eine externe Festplatte, die ich dann und wann an meinen Rechner stecke und meine Daten sichere. Unter Linux kann man es sich sogar so einrichten, dass ein Einstecken der Festplatte automatisch erkannt wird und dann dementsprechend das Backup los läuft.

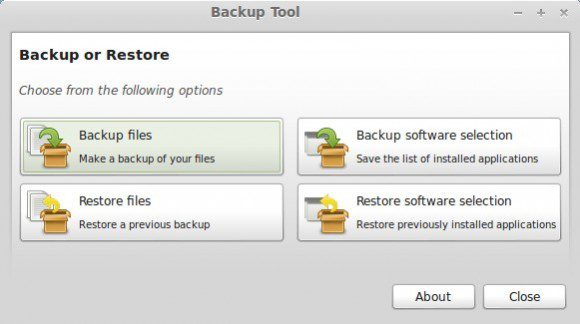

Ebenso gibt es unter Linux diverse Tools, die einem ein Backup auf einen externen Datenträger behilflich sind. Dazu gehört zum Beispiel das Datensicherungs-Werkzeug von Linux Mint. Ich persönlich scripte lieber, da ich dann die komplette Kontrolle habe.

Backup auf externe Datenträger ist eine günstige und gute Lösung. Diese ist allerdings problematisch, wenn man mehrere Rechner hat und von allen auf die gleichen Daten zugreifen möchte.

Mit ein bisschen Script-Bastelei kann man sich sogar eine eigene Zeitmaschine kreieren (tar, find, mtime …)

Nur in der Cloud – Online-Festplatte (HiDrive)

Es gibt so genannte Online-Festplatten. Stratos HiDrive lässt sich zum Beispiel mittels WebDAV oder auch SMB wunderbar unter Linux einbinden. Somit würde ich direkt online arbeiten und meine Daten scheinen gesichert zu sein.

Das Problem an dieser Sache ist, dass man sich komplett dem Service-Dienstleister anvertraut. Sollte auf dessen Seite etwas schiefgehen, ist man “gearscht”. Weiterhin ist eine permanente Internet-Verbindung notwendig und diese muss, sollte große Dateien im Spiel sein, doch recht ordentlich Bandbreite mit sich bringen.

Ich persönlich würde niemals auf nur so eine Lösung bauen. Erstens habe ich die Bandbreite dafür nicht und zweitens ist mir die Kontrolle über meine Daten komplett entzogen.

Erst letztes Jahr gab es für Firmen ein Debakel, als Nirvanix die Pforten dicht machte. Ganze zwei bis drei Wochen hat man Unternehmen eingeräumt, die Daten zu sichern. Ich wünsche es HiDrive nicht, da ich den Dienst mag, aber so etwas kann immer passieren.

Ein NAS

Ein NAS (Network Attached Storage) ist eine feine Sache. Es gibt erschwingliche Lösungen wie zum Beispiel von Synology, in die sich zwei Festplatte stecken und spiegeln lassen. EBenfalls wäre ein Einsatz des kostenlosen FreeNAS denkbar.

Ich sichere meine Daten von meinem Rechner intern mittels rsync auf das Synology. Das funktioniert wunderbar. Da ich mehr als einen Rechner habe, werden die verschiedenen Computer in separate Verzeichnisse auf dem Synology synchronisiert.

Ein Synology könnte man so einrichten, dass es von außen erreichbar ist. Will ich aber nicht, weil das ein potentieller Angriffspunkt ist. Meine Daten sind gespiegelt und dort bisher recht gut aufgehoben.

Mein wichtigsten Daten, in der Regel Dokumente oder was ich zum Arbeiten brauche, synchronisiere ich mittels rsync automatisch nach HiDrive (das Synology bietet Cronjobs an – auch mein Android-Gerät sichere ich teilweise so). Diese Daten liegen aber nicht auf meinen Rechnern, weil ich sie von allen Computern aus nutze – unter anderem meine Foto-Bibliothek.

Die Foto-Sammlung ist allerdings wiederum zu groß, um sie auf HiDrive zu schieben. Deswegen sichere ich mein NAS noch in bestimmten Abständen auf eine externe USB-Festplatte.

Nachteile bei rsync

Ich liebe rsync und eigentlich auch unison. Mit letzterem kann man echte Synchronisation realisieren. Das Problem ist nur, dass es dieses Programm bei HiDrive nicht gibt. Ja, ich könnte ein Laufwerk einbinden und unison lokal laufen lassen. Mit ist aber rsync mit SSH lieber. Zumal ich die Daten in der Regel nur in eine Richtung sichern möchte. HiDrive ist mein “Fall der Fälle”-Backup.

Das einzige Problem mit rsync ist, dass es keine lokal verschobenen Daten als solche erkennt und diese dann am Ziel einfach verschiebt. Ich verwende den Parameter --delete, der am Ziel alles löscht, was in der Quelle nicht mehr vorhanden ist.

Verschiebe ich zum Beispiel einen Ordner lokal, würde rsync den Ordner am Ziel löschen und den Ordner dann entsprechend noch einmal hochladen. Das kostet Bandbreite und kann vor allen Dingen bei großen Datenmengen ein Problem werden.

Es gibt ein paar krude Hacks mit Hardlinks, um dieses Problem zu adressieren. Das ist aber alles nicht das Gelbe vom Ei. Sollte ich wirklich in die Verlegenheit kommen, das tun zu müssen, würde ich sehr wahrscheinlich händisch sowohl auf HiDrive als auch lokal verschieben.

Cloud-Dienste – Dropbox, ownCloud, Google Drive, Ubuntu One und Konsorten

ownCloud

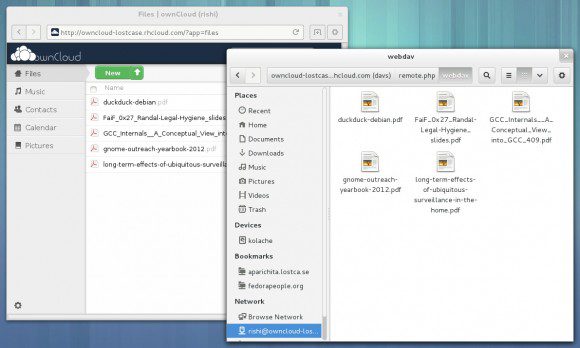

Wer anderen seine Daten nicht anvertrauen möchte, wählt wahrscheinlich den ownCloud-Weg. Die ownCloud ist derzeit als Version 6.x vorhanden und kann mit dem neuesten Sync-Client auch verschieben. Früher hat der Synchronisations-Client auch nur gelöscht und neu hochgeladen.

Das sieht nach einer passablen Lösung aus. Das Problem bei ownCloud ist, dass eine Synchronisation vieler Dateien immer noch sehr zäh ist. Weiterhin gibt es immer noch Probleme, mehr als einen Rechner “in Synchronisation” zu halten. In den vergangenen Jahren hat sich hier aber schon viel verbessert und ich habe weiterhin große Hoffnungen, dass die ownCloud irgendwann die “Eierlegende Wollmilchsau” wird.

Derzeit verwende ich den ownCloud-Sync-Client auf meinem “Reise-Rechner“. Sobald ich dann wieder zu Hause bin, kommen die sich dort gesammelten Dateien auf das NAS und werden dann entsprechend gesichert.

Ebenso verwende ich die ownCloud, um meine Adressen und Kalender zu synchronisieren – auch die von Android. Das hat bei mir bisher sehr gut funktioniert. Andere berichten von diversen Probleme, aber ich benutze nicht das hinterletzte Feld der Kalender und so weiter. Ganz normal Kalender und Adressen – erledigt seine Aufgabe wunderbar.

Weiterhin synchronisiere ich Firefox mit der ownCloud – auch über mehrere Rechner. Bei GNOME kann man zwischenzeitlich die ownCloud auch recht bequem einbinden.

Die Synology-Community bietet übrigens ownCloud-Pakete an. Somit kannst Du die eigene Datenwolke mit nur einem Klick installieren.

Google Drive und Ubuntu One

Für mich persönlich fallen die beiden eigentlich in die selbe Kategorie – nicht Plattform-unabhängig. Google Drive kann man noch einigermaßen bequem über den Browser bedienen und wer Chrome benutzt, kann die Dateien auch offline verwenden. Google hatte irgendwann mal versprochen, einen Linux-Client zu entwickeln. Bis heute hat man davon aber nichts gesehen. Es gibt Drittanbieter-Software, die mir aber nicht geheuer ist – da läuft alles über deren Server.

Ubuntu One ist bei mir nicht mehr im Einsatz, seitdem ich kein Ubuntu (also die Haupt-Distribution, die Derivate Kubuntu und Linux Mint sind im Einsatz) mehr benutze. Eigentlich schade, da ich mir bei Start des Cloud-Dienstes mehr davon versprochen habe.

Dropbox und Konsorten

Man kann über Dropbox sagen was man will – ja es ist ein Cloud-Dienst, der von der NSA möglicherweise ausspioniert wird und und und. Fakt ist aber, dass Dropbox unglaublich gut funktioniert – auch unter Linux. Ich persönlich verwende es für eigene Daten nicht mehr, da ich andere Lösungen dafür gefunden habe. Dennoch habe ich es installiert, da ich teilweise mit anderen Leuten Daten gemeinsam benutze und die haben nur Dropbox (oft unter Windows oder Mac OS X). Mehrere Rechner sind überhaupt kein Problem und LAN-Sync ist die Wucht (der Server wird zwar kontaktiert, sollten sich zwei Rechner aber im gleichen LAN befinden, kann eine Synchronisation im LAN ablaufen -> das spart jede Menge Bandbreite).

Ich wünsche mir, dass der ownCloud-Synchronisations-Client das Niveau des Dropbox-Client (stand heute) irgendwann erreicht.

Die Konsorten habe ich mir bisher weniger genau angesehen. Seit ownCloud und HiDrive gibt es für mich persönlich dafür keinen Grund mehr.

Das ist aber viel Aufwand!

Das Ganze mag sich nach einem enormen Aufwand anhören, ist es aber nicht. Das meiste ist automatisiert und man muss es wirklich nur einmal einrichten – und sich an den Workflow gewöhnen. Für mich funktioniert es auf jeden Fall und ich verwende eigentlich so gut wie keine Zeit mehr, die Prozesse anzupassen.

Es gibt keine Lösung, die für alle Szenarien gleich funktioniert. Beim Thema Backup habe ich immer das Gefühl, dass man irgendwo Abstriche machen muss. Man kann lediglich die Chance des Daten-Verlustes auf ein Minimum bringen. Dafür setzt man auf so unterschiedliche Dienste und Medien wie möglich, wobei das Ganze aus Sicht der Kosten noch gerechtfertigt sein soll

Wie gesagt muss man sich einmal auf den Hintern setzen und die Sache konfigurieren. Vorher sollte man sich noch eine Backup-Strategie zurecht legen. Vielleicht findest Du in diesem Beitrag einige Anregungen. Ich fahre mit meiner “Ein bisschen davon, ein bisschen hiervon”-Lösung bisher sehr gut.

P.S: Mein Ansatz geht mehr in Richtung “Upstream”. Irgendwann läuft punkto Datensicherung alles zusammen. Vorher sichere ich lieber einzeln (Reise-Rechner) und kombiniere die Daten dann zu Hause. Synchronisation ist zwar angenehm, aber wehe es geht etwas schief dabei – dann kann sich das auf alle anderen Rechner auch auswirken. Dieses Prinzip funktioniert natürlich wesentlich einfacher, wenn man es aus der Sicht einer einzelnen Person sieht – wie das bei mir der Fall ist.

Für den halbprofessionellen Einsatz würde ich Backuppc nutzen. Wo das dann alles liegt ist natürlich wieder eine andere Frage, ich wollt es nur mal erwähnt haben, da es frickel rsync Lösungen und Ownclound Gedöhns deutlich überlegen ist.

"... würde ich Backuppc nutzen. ... da es frickel rsync Lösungen ... überlegen ist."

Du weißt aber schon, das BackupPC intern auf rsync aufbaut, bzw. auf das smb Protokoll? *schmunzel*

Danke für den recht umfangreichen Artikel!

Ich stehe, was Backups angeht, noch ganz am Anfang und hatte mich schon durch den anderen Artikel, über die externe Platte, inspirieren lassen.

Mein Weg ist momentan der, dass ich eine 1:1 Kopie mit rsync auf dem NAS mache und dort unregelmäßig eine externe Festplatte einstecke, die dann automatisiert ebenfall gespiegelt wird.

Auf diesem Weg gibt es immer drei Versionen des kompletten /home Verzeichnis, davon eine in einer etwas älteren Version, falls mal wirklich etwas wichtiges aus versehen gelöscht wurde und nicht mehr im Papierkorb auffindbar ist.

Mangels mobiler Geräte, muss ich mir im Moment noch keine Gedanken über eine Cloud machen.

nAbend allerseits

Dazu will ich auch meinen Senf geben, weil ich viel (für meinen Geschmack zu viel) rumprobieren musste, bis ich unter Linux eine gute Backuplösung hinbekommen hab.

Also, kurz und knapp: Ich benutze BackInTime. Das vermiss ich übrigens bei deinen Aufzählungen. Für den klassischen User mit seinem Laptop und vielleicht noch einem zweiten PC Zuhaus ist das die ideale Lösung. Man muss eben nur den/die zu sichernden Ordner und das Ziel angeben. Wenn du dann deine externe Festplatte ansteckst und auf sichern klickst, schaut der was sich geändert hat und syncts. Der große Vorteil ist, dass BackInTime eine normale Ordnerstruktur anstatt vielen .tar.gz Dateien anlegt. Dabei arbeitets um des Speicherplatzes willen mit Hardlinks. So kannst du dir deine Snapshots einfach im Dateimanager anschaun.

Ach, und um es mal gesagt zu haben: Deja Dup (hast du oben mit "Linux Mint Backup Tool" beschrieben) kannst du von vorneherein vergessen. Ich habs mal eine Zeit lang benutzt und ich mag es nicht. Im Grunde genommen ist es nur ein unglaublich beschnittenes Frontend für Duplicity.

Ich musste mal eine Datei wiederherstellen, die ich etwa im vorletzten Backup hatte. Die Sache ist aber die: das geht nicht. Jedenfalls nicht mit dem Frontend. Ich musste mich erstmal ein paar Stunden hinsetzen umd mir das man von Duplicity durchlesen, bis ich dann irgendwie an den alten Snapshot rankam, in dem ich dann - nachdem ich natürlich alles entpackt habe - irgendwo die Datei fand.

Vielleicht will jetzt jemand die Tatsache einwerfen, dass die Backups von Deja Dup komprimiert sind, die von BackInTime aber nicht. Ganz ehrlich: so viel schlägt gzip nicht raus, dass sich das lohnen würde.

Hallo allerseits,

das Backup-probiere und vielleicht auch mal ein Reinfall haben möglicherweise schon einige gehabt, oder? Ich jedenfalls habe schon mal mit Unison alles gelöscht ... nur weil zur Sicherungszeit das Netz ausgeschaltet war. Hatte ich übrigens sogar selbst als Stromsparfunktion am Router eingestellt 🙁 .

Auf der Suche nach einer universellen Sicherungsstrategie bin ich bei Arecea-Backup hängengeblieben. Deja vu geht gibts/gab es nur für deb-Distributionen, BackupPC ist ein bißchen overkill für zu Hause und Areca fand ich genau richtig.

Gute Oberfläche, geht aber auch auf Konsole ... und handelt bei mir per NFS die Sicherung am QNAP.

Vielen Dank für den Artikel. Das Thema kann man nicht oft genug ansprechen.

Meine Backupstrategie sieht folgendermaßen aus:

Auf meinem Desktoprechner läuft bei jedem ersten täglichen Einschalten ein Script von rsnapshot (basiert auf rsync und arbeitet mit Hard-Links). Kurz zuvor muss ich meine externe Festplatte eingeschaltet haben. Aus Gewohnheit denke ich da eh immer dran. Die Sicherung läuft dann ohne weiteres Zutun.

Für einen Datengleichstand zwischen Desktop und Laptop verwende ich Unison, was ich ziemlich genial finde. Ich weiß, dass die „Strategie“ lange nicht perfekt ist, aber ich bin seit einiger Zeit recht zufrieden damit. Nur unterwegs kann ich so nicht auf alles zugreifen, aber das ist auch nicht wirklich nötig. Ein Smartphone besitze ich bis jetzt eh nicht. Eine Netzwerklösung ist für mich alleine jetzt noch zu viel des Guten, irgendwann vielleicht …

Owncloud habe ich wieder von meinen Servern verbannt, seitdem ich einen Blick in die Sourcen und das Versionslog geworfen habe. Mit dieser Meinung bin ich auch nicht allein. Bei den Piraten in verschiedenen Landtagen fliegt Owncloud auch wieder von den Servern runter. Dort zeigte sich ein ganz anderes Problem: Owncloud verliert auf mysteriöse Weise Daten. Das sollte eine Backuplösung auf keinen Fall!

Ein WebDAVS, welches dann komfortabel mit rsync bespielt werden kann, bekommt man auch mit Apache allein hin. Wer etwas mehr Funktionen braucht, ist evtl. auch bei Seafile gut aufgehoben. Stabile Clients gibt es für Linux, Windows, Mac, Android und iOS. Sogar ein Commandline-Client für Linux ist erhältlich. Läuft jedenfalls bei mir Klasse.

Schöner Beitrag!

Als wichtig würde ich noch mal deutlicher schreiben:

- Ein Backup sollte außerhalb der eigenen vier Wände aufbewahrt werden! Das beste Backup nützt nichts, wenn, was nie passieren möge, das Haus mal abfackelt.

- Die Backups ab und zu testen, ist alles richtig gespeichert, das Medium noch lesbar, etc.

Das sind imho zwei wichtige Punkte die oft unter den Tisch fallen.

Und dann noch, wenn die Daten bei externen Dienstleistern landen, immer lokal verschlüsseln und dann erst hochladen. Das gilt auch für HiDrive! Alles andere ist grob fahrlässig.

Hast du dich eigentlich mittlerweile mal mit Seafile auseinander gesetzt? Ich habe das getan und kann nur sagen: wow. Was die Geschwindigkeit angeht ist es besser als Dropbox. Es läuft hier mit mittlerweile knapp hundert usern echt gut.

Für Kalender-Sync integriere ich mir jetzt noch DAVical in Roundcube und dann brauch ich die restl. Owncloud-Features auch nicht mehr 😉

Seafile ist für mich keine Option, da es bei einem normalen Hosting-Paket nicht installierbar ist. Intern brauche ich es nicht, weil mir da rsync reicht.

Sofern ich das sehe, kann man die KOntakte damit auch nicht synchronisieren.

Deswegen habe ich mich damit noch nicht befasst ...

Das kriegt man schon installiert. Die Installation ist nur ein klein wenig komplexer. Ich überlege gerade separat allein für Kontakte Owncloud zu nutzen. Der Performance-Gewinn bei Seafile lässt einen vor Owncloud nämlich nur noch grausen...

Also meine Strategie ist recht simple aber funktioniert für mich absolut zufriedenstellend und wirklich gut mit wenigen manuellen Eingriffen:

Wechselrahmen mit SATA HD die ich im laufenden Betrieb einfach verriegele und damit aktiviere. Dann auf dem Desktop manuell "Lucky-Backup" starten Backup anklicken - fertig. Innerhalb von LB habe ich 2 Backupsätze definiert: einmal die Daten und einmal das Profil. Beides wird auf die externe SATA HD gesichert. Wenn wenig geändert wurde hab ich den Vorteil von rsync ( LB ist "nur" ein graphisches Frontend für rsync) hinsichtlich reine Delta-Sicherung und es geht sehr schnell.

Man kann generell jeden einzelnen Backup Satz starten oder auch alle zusammen. Diese Backup sätze würden sich auch per script bedienen lassen und somit auch wieder automatisieren via HW-change wie hier im Blog schon beschrieben. Für mich ist die Sicherung m LB absolut perfekt hinsichtlich Nutzen/Aufwand. Gruss, Mike

Ich würde mal noch die s3tools in Rennen werfen. Für 0,01$/GB (Glacier) eigentlich ein Schnäppchen und Amazon traue ich einen Datenverlust so schnell eigentlich nicht zu 😉

die s3tools verschlüsseln auch mit gpg vor dem Upload.

Mit ein bisschen Shell-magic und md5 checksum kann man sich auch was basteln dass nur neue Dateien hochgeladen werden.

Super Artikel...ich muss aber ehrlich sagen, die Cloud-Services sprechen mit aktuell in Puncto "tatsächlicher Sicherheit" noch nicht wirklich an, weswegen ich die Backups lieber physisch bei mir liegen habe - mit welcher Software auch immer und meist ist das Handling denkbar einfach (auch für Laien):

Auch wenn der Beitrag schon etwas älter ist (bin gerade erst zufällig darauf gestoßen). Danke für den Artikel.

Mir wurde mal von einem Admin eingetrichtert, ein Backup sollte dem 3-2-1 Prinzip entsprechen:

3 Kopien der Dateien, auf

2 verschiedenen Medien

1 ausserhalb des Büros/Hauses bzw. online.

Mit dieser Vorgehensweise hat man quasi alle Fälle abgedeckt. Damit ist man auch gegen den Fall gewappnet, dass z. B. der Online-Backup-Anbieter nicht mehr erreichbar ist.

Natürlich sollten die Daten des Backups, dass man ausserhalb der Räume aufbewahrt (oder online erfolgt) verschlüsselt sein.

Das habe ich früher über eine externe Platte gelöst, die ich bei meinen Eltern aufbewahrt habe und so alle 1-2 Wochen gewechselt habe (somit war die Verschlüsselung nicht ganz so wichtig). Nur wohne ich nicht mehr wirklich in der Nähe meiner Eltern und mir war das irgendwann auch zu lästig.

Das mache ich heute nur noch mit meiner recht umfangreichen Musik-/Videosammlung, da reicht es auch aus, wenn ich alle 2-3 Monate mal eine Kopie ausserhalb der Wohnung lagere. Damit schaffe ich es auch, die Kosten für mein Online-Backup in Grenzen zu halten.

Somit:

Ein Online-Backup ersetzt nicht das lokale Backup, das lokale Backup ersetzt aber auch nicht das Online-Backup (bzw. externe BackUp).

Viele hier genannte Online-Anbieter sind keine echten "Backup-Anbieter", sondern bieten nur Storage im Netz. Somit muss man sich selber um die Verschlüsselung, die Backup-Tools (Versionierung, etc..) kümmern, usw..

Echte OnlineBackup-Anbieter helfen zum Teil auch das Problem mit der Bandbreite zu beseitigen, da nicht jedesmal die gesamte Datei nach einer Änderung hochgeladen werden muss, sondern nur die geänderten Dateiblöcke.

Ich habe dazu als Lösung CrashPlanPROe entdeckt, das läuft bei mir auf einer Synology, auf einem Mac und einer Windows-Kiste. Hier werden die Daten auf meinen Rechnern verschlüsselt und dann über eine verschlüsselte Leitung übertragen. Die Daten werden im gleichen Zug komprimiert und dedupliziert. Das klappt über meine DSL 16.000-Leitung recht gut.

Als Anbieter habe ich einige Zeit lang crashplan.nl verwendet, nutze jetzt aber seit über einem Jahr oecherwolke.de, da dort auch garantiert wird, dass die Daten in Deutschland bleiben. Die nutzen die gleiche Software, die Preise sind etwa vergleichbar.

Besonders "geil" finde ich das Feature, dass ich von meinem Mac ein Backup über CrashPlan auf meiner Synology machen kann, ein Backup online und auf eine externe Platte.. alles mit dem gleichen Tool und ich kann jedesmal einstellen, welche Daten ich wo und wie oft sichern will. Funzt sehr gut.

[…] Sharing Under Your Control - ownCloud. Linux | Android | Spiele | Open-Source | Server | Desktop | Security. Datenverlust ist oft eine Katastrophe. Deswegen versuchen wir unsere Daten so gut wie möglich zu […]

Wie sieht es mit Elephantdrive aus, diesen Anbieter kann man super mit den Geräten von QNAP und Synology nutzen.

Die Daten werden dorch versioniert und auch beim lokalen Löschen im Cloud beibehalten, ein Löschen kann somit verhindert werden, wo andere die Dateien nur Syncen (Dropbox etc.).

MfG

alias

STRATO HiDrive unterstützt rsync wunderbar! Ich muss dir leider widersprechen, das rync Protokoll wird wunderbar unterstützt, ist rasend schnell und zuverlässig. Nur das 5GB-FreeHidrive ist auf webdav reduziert. Alle anderen Pakete können einiges an Protokollen! Verschlüsselung auf Online-Speichern ist natürlich bei allen Anbietern ein muss. Was auch super funktioniert ist das rsyncen von Truecrypt-Containern 🙂

Disclosure: Ich arbeite für STRATO.

Die Protokolle sind wie folgt:

FTP (keine Verschlüsselung)

FTPS (verschlüsselt per TLS)

WebDAV (wahlweise verschlüsselt oder unverschlüsselt)

SMB / CIFS (unverschlüsselt, Verschlüsselung nur mit OpenVPN)

rsync (wahlweise verschlüsselt oder unverschlüsselt)

SFTP (verschlüsselt)

SCP (verschlüsselt)

http://www.strato-faq.de/article/2136/HiDrive:-Welche-Verbindungsprotokolle-werden-angeboten.html

Tolle Aufstellung und Übersicht des Themas! Ich hätte es gerne gesehen wenn dem Thema verschlüsselter Backups etwas mehr Platz eingeräumt worden wäre, was besonders für Ablageorte in Netz- bzw. Cloudspeichern zum Tragen kommt.

Das Optimum ist für mich rsync, egal ob es auf eine portable Festplatte geht oder zwischen zwei Servern im Netz in Verbindung mit SSH.